No81.

On Amazon Aurora, a business is operating a database. Every nightfall, the database is inactive. When user traffic surges in the early hours, an application that makes large reads on the database will face performance concerns. When reading from the database during these peak hours, the program encounters timeout issues. Due to the lack of a dedicated operations crew, the organization need an automated solution to solve performance concerns. Which activities should a solutions architect take to ensure that the database automatically adjusts to the increasing read load? (Select two.)

A. Migrate the database to Aurora Serverless.

B. Increase the instance size of the Aurora database.

C. Configure Aurora Auto Scaling with Aurora Replicas.

D. Migrate the database to an Aurora multi-master cluster.

E. Migrate the database to an Amazon RDS for MySQL Multi-AZ deployment.

Amazon Aurora를 사용하여 데이터베이스를 운영하고 있습니다. 매일 밤 데이터베이스는 비활성화됩니다. 사용자 트래픽이 이른 시간에 급증하면 데이터베이스에서 많은 양의 읽기를 수행하는 애플리케이션이 성능 문제에 직면하게 됩니다. 이러한 피크 시간 동안 데이터베이스에서 읽을 때 프로그램에서 시간 초과 문제가 발생합니다. 전담 운영 인력이 없기 때문에 조직은 성능 문제를 해결하기 위한 자동화된 솔루션이 필요합니다. 데이터베이스가 증가하는 읽기 로드에 자동으로 조정되도록 솔루션 설계자가 취해야 하는 활동은 무엇입니까? (2개를 선택하세요.)

A. 데이터베이스를 Aurora Serverless로 마이그레이션합니다.

B. Aurora 데이터베이스의 인스턴스 크기를 늘립니다.

C. Aurora 복제본을 사용하여 Aurora Auto Scaling을 구성합니다.

D. 데이터베이스를 Aurora 멀티 마스터 클러스터로 마이그레이션합니다.

E. 데이터베이스를 Amazon RDS for MySQL 다중 AZ 배포로 마이그레이션합니다.

A,C

자동 조정에 대한 질문입니다.

AWS의 Aurora serverless 사용 사례는 사용 빈도가 낮은 애플리케이션입니다.

용량이 적은 블로그 사이트와 같이 하루 또는 일주일에 몇 번 몇 분만 사용하는 응용프로그램이 있으며 활성 상태일 때만 비용을 지불하면 되는 비용 효율적인 데이터베이스를 원합니다. Aurora Serverless v1에서는 사용하는 데이터베이스 리소스에 대해서만 비용을 지불합니다.

다음은 자동 확장의 사용 사례입니다. 연결 또는 워크로드가 감소하면 Aurora Auto Scaling은 불필요한 Aurora Replica를 제거하여 사용하지 않는 프로비저닝된 DB 인스턴스에 대한 비용을 지불하지 않도록 합니다.

(5월31일, 7월21일 기출)

No82.

Users may get past performance reports from a company's website. The website requires a solution that can grow to suit the company's worldwide website requirements. The solution should be cost-effective, minimize infrastructure resource provisioning, and deliver the quickest reaction time feasible. Which mix of technologies might a solutions architect propose in order to satisfy these requirements?

A. Amazon CloudFront and Amazon S3

B. AWS Lambda and Amazon DynamoDB

C. Application Load Balancer with Amazon EC2 Auto Scaling

D. Amazon Route 53 with internal Application Load Balancers

사용자는 회사 웹사이트에서 과거 실적 보고서를 받을 수 있습니다. 웹 사이트에는 회사의 전세계 웹 사이트 요구 사항에 맞게 확장할 수 있는 솔루션이 필요합니다. 솔루션은 "비용 효율적"이어야 하고, 인프라 리소스 프로비저닝을 최소화하고, 실현 가능한 가장 빠른 반응 시간을 제공해야 합니다. 솔루션 설계자는 이러한 요구 사항을 충족하기 위해 어떤 기술 조합을 제안할 수 있습니까?

A. Amazon CloudFront 및 Amazon S3

B. AWS Lambda 및 Amazon DynamoDB

C. Amazon EC2 Auto Scaling이 있는 Application Load Balancer

D. 내부 Application Load Balancer가 있는 Amazon Route 53

A

S3는 웹 사이트에 가장 적합하며 인프라를 추가하지 않고도 필요에 따라 확장할 수 있습니다.

(EC2 옵션이 있는 경우 여기서 제외됩니다.)

CloudFront는 더 나은 콘텐츠 배포를 추가합니다.

(6월6일, 6월16일, 7월26일 기출)

No83.

Previously, a corporation moved their data warehousing solution to AWS. Additionally, the firm has an AWS Direct Connect connection. Through the use of a visualization tool, users in the corporate office may query the data warehouse. Each query answered by the data warehouse is on average 50 MB in size, whereas each webpage supplied by the visualization tool is around 500 KB in size. The data warehouse does not cache the result sets it returns. Which approach results in the LOWEST OUTGOING DATA TRANSFER COSTS FOR THE COMPANY?

A. Host the visualization tool on premises and query the data warehouse directly over the internet.

B. Host the visualization tool in the same AWS Region as the data warehouse. Access it over the internet.

C. Host the visualization tool on premises and query the data warehouse directly over a Direct Connect connection at a location in the same AWS Region.

D. Host the visualization tool in the same AWS Region as the data warehouse and access it over a DirectConnect connection at a location in the same Region.

데이터 웨어하우징 솔루션을 AWS로 이전했습니다. 또한 AWS Direct Connect 연결을 가지고있습니다. 시각화 도구를 사용하여 데이터 웨어하우스를 쿼리할 수 있습니다. 데이터 웨어하우스에서 응답하는 각 쿼리의 크기는 평균 50MB인 반면 시각화 도구에서 제공하는 각 웹 페이지의 크기는 약 500KB입니다. 데이터 웨어하우스는 반환하는 결과 집합을 캐시하지 않습니다. 가장 낮은 송신 데이터 전송 비용을 위한 접근 방식은 무엇입니까?

A. 온프레미스에서 시각화 도구를 호스팅하고 인터넷을 통해 직접 데이터 웨어하우스를 쿼리합니다.

B. 데이터 웨어하우스와 동일한 AWS 리전에서 시각화 도구를 호스팅합니다. 인터넷을 통해 액세스하십시오.

C. 온프레미스에서 시각화 도구를 호스팅하고 동일한 AWS 리전의 위치에서 Direct Connect 연결을 통해 직접 데이터 웨어하우스를 쿼리합니다.

D. 데이터 웨어하우스와 동일한 AWS 리전에서 시각화 도구를 호스팅하고 동일한 리전의 위치에서 DirectConnect 연결을 통해 액세스합니다.

D

시각화 결과가 크기가 더 작다고하니 시각화까지는 같은곳에서하고 시각화 결과만 보내주는 방식입니다.

(6월6일, 6월16일, 6월18일 기출)

No84.

A startup has developed an application that gathers data from Internet of Things (IoT) sensors installed on autos. Through Amazon Kinesis Data Firehose, the data is transmitted to and stored in Amazon S3. Each year, data generates billions of S3 objects. Each morning, the business retrains a set of machine learning (ML) models using data from the preceding 30 days. Four times a year, the corporation analyzes and trains other machine learning models using data from the preceding 12 months. The data must be accessible with a minimum of delay for a period of up to one year. Data must be preserved for archive reasons after one year. Which storage system best satisfies these criteria in terms of cost-effectiveness?

A. Use the S3 Intelligent-Tiering storage class. Create an S3 Lifecycle policy to transition objects to S3 Glacier Deep Archive after 1 year.

B. Use the S3 Intelligent-Tiering storage class. Configure S3 Intelligent-Tiering to automativally move objects to S3 Glacier Deep Archive after 1 year.

C. Use the S3 Standard-Infrequent Access (S3 Standard-IA) storage class. Create an S3 Lifecycle policy to transition objects to S3 Glacier Deep Archive after 1 year.

D. Use the S3 Standard storage class. Create an S3 Lifecycle policy to transition objects to S3 Standard-Infrequent Access (S3 Standard-IA) after 30 days, and then to S3 Glacier Deep Archive after 1 year.

한 스타트업이 자동차에 설치된 사물인터넷(IoT) 센서에서 데이터를 수집하는 애플리케이션을 개발했습니다. Amazon Kinesis Data Firehose를 통해 데이터가 Amazon S3로 전송되고 저장됩니다. 매년 데이터는 수십억 개의 S3 객체를 생성합니다. 매일 아침 비즈니스는 이전 30일 동안의 데이터를 사용하여 일련의 기계 학습(ML) 모델을 재교육합니다. 회사는 1년에 4번 이전 12개월의 데이터를 사용하여 다른 기계 학습 모델을 분석하고 교육합니다. 데이터는 최대 1년 동안 최소한의 지연으로 액세스할 수 있어야 합니다. 데이터는 1년 후에 아카이브를 위해 보존해야 합니다. 비용 효율성 측면에서 이러한 기준을 가장 잘 충족하는 스토리지 시스템은 무엇입니까?

A. S3 Intelligent-Tiering 스토리지 클래스를 사용하십시오. S3 수명 주기 정책을 생성하여 1년 후 객체를 S3 Glacier Deep Archive로 전환합니다.

B. S3 Intelligent-Tiering 스토리지 클래스를 사용합니다. 1년 후에 객체를 자동으로 S3 Glacier Deep Archive로 이동하도록 S3 Intelligent-Tiering을 구성합니다.

C. S3 Standard-Infrequent Access(S3 Standard-IA) 스토리지 클래스를 사용합니다. S3 수명 주기 정책을 생성하여 1년 후 객체를 S3 Glacier Deep Archive로 전환합니다.

D. S3 Standard 스토리지 클래스를 사용합니다. S3 수명 주기 정책을 생성하여 30일 후에 객체를 S3 Standard-Infrequent Access(S3 Standard-IA)로 전환하고 1년 후에 S3 Glacier Deep Archive로 전환합니다.

D

- 첫 30일 - 매일 아침 데이터 액세스(예측 가능, 자주) – S3 표준

- 30일 후, 연간 4회 액세스 – S3 자주 액세스 안 함

- 데이터 보존 - S3 Glacier Deep Archive

액세스 패턴이 변경될 때 S3 Intelligent-Tiering이 적합하므로 B가 아닙니다.

(5월31일 기출)

No85.

A business chooses to transition from on-premises to the AWS Cloud its three-tier web application. The new database must be able to scale storage capacity dynamically and conduct table joins. Which AWS service satisfies these criteria?

A. Amazon Aurora

B. Amazon RDS for SqlServer

C. Amazon DynamoDB Streams

D. Amazon DynamoDB on-demand

기업은 3계층 웹 애플리케이션을 온프레미스에서 AWS 클라우드로 전환하기로 선택합니다. 새 데이터베이스는 저장 용량을 동적으로 확장하고 테이블 조인을 수행할 수 있어야 합니다. 이 기준을 충족하는 AWS 서비스는 무엇입니까?

A. Amazon Aurora

B. Amazon RDS for SqlServer

C. Amazon DynamoDB Streams

D. Amazon DynamoDB on-demand

A

테이블 조인을 수행할 수 있어야된다는 지문에서 관계형 DB 라는 걸 알 수 있습니다. (DynamoDB 탈락)

A, B 모두 스케일 조절은 잘되는데, B의 경우 오토스케일링을 활성화해야하므로 A가 좀 더 적합합니다.

AWS 시험에서는 질문 대부분 관계형일 경우 오로라 비관계형일 경우 DynamoDB가 정답인 경우가 대부분입니다.

(6월 25일 기출)

No86.

On a cluster of Amazon Linux EC2 instances, a business runs an application. The organization is required to store all application log files for seven years for compliance purposes. The log files will be evaluated by a reporting program, which will need concurrent access to all files. Which storage system best satisfies these criteria in terms of cost-effectiveness?

A. Amazon Elastic Block Store (Amazon EBS)

B. Amazon Elastic File System (Amazon EFS)

C. Amazon EC2 instance store

D. Amazon S3

Amazon Linux EC2 인스턴스 클러스터에서 기업은 애플리케이션을 실행합니다. 조직은 규정 준수를 위해 모든 애플리케이션 로그 파일을 7년 동안 저장해야 합니다. 로그 파일은 모든 파일에 대한 동시 액세스가 필요한 보고 프로그램에 의해 평가됩니다. 비용 효율성 측면에서 이러한 기준을 가장 잘 충족하는 스토리지 시스템은 무엇입니까?

A. Amazon Elastic Block Store (Amazon EBS)

B. Amazon Elastic File System (Amazon EFS)

C. Amazon EC2 instance store

D. Amazon S3

D

S3 : 비용효과적이며 동시 액세스를 지원합니다. (cost effective, concurrent is supported)

(6월6일, 6월16일 기출)

No87.

Currently, a company's legacy application relies on an unencrypted Amazon RDS MySQL database with a single instance. All current and new data in this database must be encrypted to comply with new compliance standards. How is this to be achieved?

A. Create an Amazon S3 bucket with server-side encryption enabled. Move all the data to Amazon S3. Delete the RDS instance.

B. Enable RDS Multi-AZ mode with encryption at rest enabled. Perform a failover to the standby instance to delete the original instance.

C. Take a Snapshot of the RDS instance. Create an encrypted copy of the snapshot. Restore the RDS instance from the encrypted snapshot.

D. Create an RDS read replica with encryption at rest enabled. Promote the read replica to master and switch the application over to the new master. Delete the old RDS instance.

현재 회사의 레거시 애플리케이션은 단일 인스턴스가 있는 암호화되지 않은 Amazon RDS MySQL 데이터베이스에 의존합니다. 이 데이터베이스의 모든 현재 및 새 데이터는 새로운 규정 준수 표준을 준수하도록 암호화되어야 합니다. 이것은 어떻게 달성될 수 있습니까?

A. 서버 측 암호화가 활성화된 Amazon S3 버킷을 생성합니다. 모든 데이터를 Amazon S3로 이동합니다. RDS 인스턴스를 삭제합니다.

B. 미사용 데이터 암호화가 활성화된 RDS 다중 AZ 모드를 활성화합니다. 대기 인스턴스로 장애 조치를 수행하여 원본 인스턴스를 삭제합니다.

C. RDS 인스턴스의 스냅샷을 만듭니다. 스냅샷의 암호화된 복사본을 만듭니다. 암호화된 스냅샷에서 RDS 인스턴스를 복원합니다.

D. 미사용 데이터 암호화가 활성화된 RDS 읽기 전용 복제본을 생성합니다. 읽기 전용 복제본을 마스터로 승격하고 애플리케이션을 새 마스터로 전환합니다. 이전 RDS 인스턴스를 삭제합니다.

C

스냅샷 생성 - 암호화 - 복원

(6월17일, 7월23일 기출)

No88.

A business has two virtual private clouds (VPCs) labeled Management and Production. The Management VPC connects to a single device in the data center using VPNs via a customer gateway. The Production VPC is connected to AWS through two AWS Direct Connect connections via a virtual private gateway. Both the Management and Production VPCs communicate with one another through a single VPC peering connection. What should a solutions architect do to minimize the architecture's single point of failure?

A. Add a set of VPNs between the Management and Production VPCs.

B. Add a second virtual private gateway and attach it to the Management VPC.

C. Add a second set of VPNs to the Management VPC from a second customer gateway device.

D. Add a second VPC peering connection between the Management VPC and the Production VPC.

기업에는 관리 및 생산이라는 레이블이 붙은 두 개의 가상 사설 클라우드(VPC)가 있습니다. 관리 VPC는 고객 게이트웨이를 통해 VPN을 사용하여 데이터 센터의 단일 장치에 연결합니다. 생산 VPC는 가상 프라이빗 게이트웨이를 통해 두 개의 AWS Direct Connect 연결을 통해 AWS에 연결됩니다. 관리 및 생산 VPC는 모두 단일 VPC 피어링 연결을 통해 서로 통신합니다. 아키텍처의 단일 실패 지점을 최소화하기 위해 솔루션 설계자는 무엇을 해야 합니까?

A. 관리 VPC와 프로덕션 VPC 간에 VPN 세트를 추가합니다.

B. 두 번째 가상 프라이빗 게이트웨이를 추가하고 관리 VPC에 연결합니다.

C. 두 번째 고객 게이트웨이 장치에서 관리 VPC로 두 번째 VPN 세트를 추가합니다.

D. 관리 VPC와 프로덕션 VPC 간에 두 번째 VPC 피어링 연결을 추가합니다.

C

이 문제에서 알아야할 것은 VPC Peering은 단일 실패지점이 아니라는 것입니다. 이미 VPC Peering으로 연결된 관리 VPC와 생산 VPC 연결에서는 추가 연결을 생각하지 않아도 됩니다. 생산 VPC와 AWS는 이미 2개의 DX로 연결되어 있으니 이것도 제외됩니다. 남은 것은 관리 VPC와 데이터센터간 단일 VPN으로 연결된 것인데, 이것을 2개로 만들면 됩니다.

(6월17일, 7월18일, 7월21일, 7월23일, 7월 30일 기출)

No89.

A legal company must communicate with the public. Hundreds of files must be publicly accessible. Anyone is banned from modifying or deleting the files before to a specified future date. Which solution satisfies these criteria the SAFEST way possible?

A. Upload all flies to an Amazon S3 bucket that is configured for static website hosting. Grant read-only IAM permissions to any AWS principals that access the S3 bucket until the designated date.

B. Create a new Amazon S3 bucket with S3 Versioning enabled. Use S3 Object Lock with a retention period in accordance with the designated date. Configure the S3 bucket for static website hosting. Set an S3 bucket policy to allow read-only access to the objects.

C. Create a new Amazon S3 bucket with S3 Versioning enabled. Configure an event trigger to run an AWS Lambda function in case of object modification or deletion. Configure the Lambda function to replace the objects with the original versions from a private S3 bucket.

D. Upload all files to an Amazon S3 bucket that is configured for static website hosting. Select the folder that contains the files. Use S3 Object Lock with a retention period in accordance with the designated date. Grant read-only IAM permissions to any AWS principals that access the S3 bucket.

법률 회사는 대중과 소통해야 합니다. 수백 개의 파일에 공개적으로 액세스할 수 있어야 합니다. 누구든지 지정된 날짜 이전에 파일을 수정하거나 삭제할 수 없습니다. 가능한 가장 안전한 방법으로 이러한 기준을 충족하는 솔루션은 무엇입니까?

A. 모든 파일을 정적 웹 사이트 호스팅용으로 구성된 Amazon S3 버킷에 업로드합니다. 지정된 날짜까지 S3 버킷에 액세스하는 모든 AWS 보안 주체에게 읽기 전용 IAM 권한을 부여합니다.

B. S3 버전 관리가 활성화된 새 Amazon S3 버킷을 생성합니다. 지정된 날짜에 따라 보존 기간이 있는 S3 Object Lock을 사용합니다. 정적 웹 사이트 호스팅을 위해 S3 버킷을 구성합니다. 객체에 대한 읽기 전용 액세스를 허용하도록 S3 버킷 정책을 설정합니다.

C. S3 버전 관리가 활성화된 새 Amazon S3 버킷을 생성합니다. 객체 수정 또는 삭제 시 AWS Lambda 함수를 실행하도록 이벤트 트리거를 구성합니다. 객체를 프라이빗 S3 버킷의 원래 버전으로 교체하도록 Lambda 함수를 구성합니다.

D. 정적 웹 사이트 호스팅용으로 구성된 Amazon S3 버킷에 모든 파일을 업로드합니다. 파일이 포함된 폴더를 선택합니다. 지정된 날짜에 따라 보존 기간이 있는 S3 Object Lock을 사용합니다. S3 버킷에 액세스하는 모든 AWS 보안 주체에게 읽기 전용 IAM 권한을 부여합니다.

B

A. IAM 권한이 공용 액세스에 적합하지 않기 때문에 오답입니다.

C. Lambda가 필요 없기 때문에 오답입니다.

D. A와 같은 이유로 오답입니다.

(6월6일, 6월16일, 6월18일, 7월21일 기출)

No90.

A solutions architect must create a system for archiving client case files. The files are critical corporate assets. The file count will increase over time. Multiple application servers running on Amazon EC2 instances must be able to access the files concurrently. There must be built-in redundancy in the solution. Which solution satisfies these criteria?

A. Amazon Elastic File System (Amazon EFS)

B. Amazon Elastic Block Store (Amazon EBS)

C. Amazon S3 Glacier Deep Archive

D. AWS Backup

솔루션 설계자는 클라이언트 사례 파일을 보관하기 위한 시스템을 만들어야 합니다. 파일은 중요한 기업 자산입니다. 파일 수는 시간이 지남에 따라 증가합니다. Amazon EC2 인스턴스에서 실행되는 여러 애플리케이션 서버는 파일에 동시에 액세스할 수 있어야 합니다. 솔루션에는 기본 제공 중복성이 있어야 합니다. 어떤 솔루션이 이러한 기준을 충족합니까?

A. Amazon Elastic File System (Amazon EFS)

B. Amazon Elastic Block Store (Amazon EBS)

C. Amazon S3 Glacier Deep Archive

D. AWS Backup

A

Amazon EC2, Amazon ECS 및 AWS Lambda를 포함한 여러 컴퓨팅 인스턴스가 동시에 Amazon EFS 파일 시스템에 액세스할 수 있습니다

(6월17일 기출)

No91.

A business is prepared to use Amazon S3 to store sensitive data. Data must be encrypted at rest for compliance purposes. Auditing of encryption key use is required. Each year, keys must be rotated. Which solution satisfies these parameters and is the MOST OPTIMAL in terms of operational efficiency?

A. Server-side encryption with customer-provided keys (SSE-C)

B. Server-side encryption with Amazon S3 managed keys (SSE-S3)

C. Server-side encryption with AWS KMS (SSE-KMS) customer master keys (CMKs) with manual rotation

D. Server-side encryption with AWS KMS (SSE-KMS) customer master keys (CMKs) with automatic rotation

기업은 Amazon S3를 사용하여 민감한 데이터를 저장할 준비가 되어 있습니다. 규정 준수를 위해 데이터를 암호화해야 합니다. 암호화 키 사용에 대한 감사가 필요합니다. 매년 키를 교체해야 합니다. 어떤 솔루션이 이러한 매개변수를 충족하고 운영 효율성 측면에서 가장 최적입니까?

A. 고객 제공 키를 사용한 서버 측 암호화(SSE-C)

B. Amazon S3 관리형 키를 사용한 서버 측 암호화(SSE-S3)

C. 수동 교체가 있는 AWS KMS(SSE-KMS) 고객 마스터 키(CMK)를 사용한 서버 측 암호화

D. 자동 교체 기능이 있는 AWS KMS(SSE-KMS) 고객 마스터 키(CMK)를 사용한 서버 측 암호화

D

2022년 5월, AWS KMS는 AWS 관리형 키에 대한 교체 일정을 3년(약 1,095일)에서 매년(약 365일)으로 변경했습니다. 새 AWS 관리형 키는 생성된 후 1년이 지나, 그 후 대략 매년 자동으로 교체됩니다. 기존 AWS 관리형 키는 가장 최근 회전 후 1년이 지나, 그 후에는 매년 자동으로 교됩니다.

운영 효율성 측면에서 보면 자동 교체를 통한 AWS KMS(SSE-KMS) 고객 마스터 키(CMK)를 통한 서버 측 암호화가 최적입니다.

(6월17일, 6월25일, 7월18일, 7월23일, 7월29일, 7월30일 기출)

No92.

A significant media corporation uses AWS to host a web application. The corporation intends to begin caching secret media files in order to provide dependable access to them to consumers worldwide. Amazon S3 buckets are used to store the material. The organization must supply material rapidly, regardless of the origin of the requests. Which solution will satisfy these criteria?

A. Use AWS DataSync to connect the S3 buckets to the web application.

B. Deploy AWS Global Accelerator to connect the S3 buckets to the web application.

C. Deploy Amazon CloudFront to connect the S3 buckets to CloudFront edge servers.

D. Use Amazon Simple Queue Service (Amazon SQS) to connect the S3 buckets to the web application.

미디어 회사는 AWS를 사용하여 웹 애플리케이션을 호스팅합니다. 회사는 전 세계 소비자에게 신뢰할 수 있는 액세스를 제공하기 위해 비밀 미디어 파일 캐싱을 시작할 계획입니다. Amazon S3 버킷은 자료를 저장하는 데 사용됩니다. 조직은 요청의 출처에 관계없이 신속하게 자료를 공급해야 합니다. 어떤 솔루션이 이러한 기준을 충족할까요?

A. AWS DataSync를 사용하여 S3 버킷을 웹 애플리케이션에 연결합니다.

B. AWS Global Accelerator를 배포하여 S3 버킷을 웹 애플리케이션에 연결합니다.

C. Amazon CloudFront를 배포하여 S3 버킷을 CloudFront 엣지 서버에 연결합니다.

D. Amazon Simple Queue Service(Amazon SQS)를 사용하여 S3 버킷을 웹 애플리케이션에 연결합니다.

C

GA (Global Accelerator)는 대기 시간을 줄이지만 캐시를 구현하지 않습니다. 반면 CloudFront 서비스는 캐쉬도 합니다.

(6월17일 기출)

No93.

A business is creating a website that will store static photos in an Amazon S3 bucket. The company's goal is to reduce both latency and cost for all future requests. How should a solutions architect propose a service configuration?

A. Deploy a NAT server in front of Amazon S3.

B. Deploy Amazon CloudFront in front of Amazon S3.

C. Deploy a Network Load Balancer in front of Amazon S3.

D. Configure Auto Scaling to automatically adjust the capacity of the website.

한 비즈니스에서 Amazon S3 버킷에 정적 사진을 저장할 웹 사이트를 만들고 있습니다. 회사의 목표는 모든 향후 요청에 대한 대기 시간과 비용을 줄이는 것입니다. 솔루션 설계자는 서비스 구성을 어떻게 제안해야 합니까?

A. Amazon S3 앞에 NAT 서버를 배포합니다.

B. Amazon S3 앞에 Amazon CloudFront를 배포합니다.

C. Amazon S3 앞에 Network Load Balancer를 배포합니다.

D. Auto Scaling을 구성하여 웹사이트의 용량을 자동으로 조정합니다.

B

STATIC ㅡ> S3 + Cloudfront

(6월6일, 6월9일, 6월16일, 7월21일, 7월23일 기출)

No94.

Using seven Amazon EC2 instances, a business runs its web application on AWS. The organization needs that DNS queries provide the IP addresses of all healthy EC2 instances. Which policy should be employed to comply with this stipulation?

A. Simple routing policy

B. Latency routing policy

C. Multi-value routing policy

D. Geolocation routing policy

7개의 Amazon EC2 인스턴스를 사용하여 기업은 AWS에서 웹 애플리케이션을 실행합니다. 조직은 DNS 쿼리가 모든 정상 EC2 인스턴스의 IP 주소를 제공해야 합니다. 이 규정을 준수하려면 어떤 정책을 사용해야 합니까?

A. Simple routing policy

B. Latency routing policy

C. Multi-value routing policy

D. Geolocation routing policy

C

[Route53 라우팅 정책]

단순 라우팅 정책(Simple routing policy) : 도메인에 대해 특정 기능을 수행하는 하나의 리소스만 있는 경우(예: example.com 웹 사이트의 콘텐츠를 제공하는 하나의 웹 서버)에 사용합니다.

장애 조치 라우팅 정책(Failover routing policy) : 액티브-패시브 장애 조치를 구성하려는 경우에 사용합니다.

지리 위치 라우팅 정책(Geolocation routing policy) : 사용자의 위치에 기반하여 트래픽을 라우팅하려는 경우에 사용합니다.

지리 근접 라우팅 정책(Geoproximity routing policy) : 리소스의 위치를 기반으로 트래픽을 라우팅하고 필요에 따라 한 위치의 리소스에서 다른 위치의 리소스로 트래픽을 보내려는 경우에 사용합니다.

지연 시간 라우팅 정책(Latency routing policy) : 여러 AWS 리전에 리소스가 있고 왕복 시간이 적은 최상의 지연 시간을 제공하는 리전으로 트래픽을 라우팅하려는 경우에 사용합니다.

다중 응답 라우팅 정책(Multivalue answer routing policy) : Route 53이 DNS 쿼리에 무작위로 선택된 최대 8개의 정상 레코드로 응답하게 하려는 경우에 사용합니다.

가중치 기반 라우팅 정책(Weighted routing policy) : 사용자가 지정하는 비율에 따라 여러 리소스로 트래픽을 라우팅하려는 경우에 사용합니다.

(6월17일, 6월25일, 7월23일, 7월29일, 7월30일 기출)

No95.

A business wishes to implement a shared file system for its.NET application servers and Microsoft SQL Server databases that are hosted on Amazon EC2 instances running Windows Server 2016. The solution must interact with the corporate Active Directory domain, be very durable, be managed by AWS, and provide high levels of throughput and IOPS. Which solution satisfies these criteria?

A. Use Amazon FSx for Windows File Server.

B. Use Amazon Elastic File System (Amazon EFS).

C. Use AWS Storage Gateway in file gateway mode.

D. Deploy a Windows file server on two On Demand instances across two Availability Zones.

기업은 Windows Server 2016을 실행하는 Amazon EC2 인스턴스에서 호스팅되는 Microsoft SQL Server 데이터베이스 및 .NET 애플리케이션 서버용 공유 파일 시스템을 구현하려고 합니다. 솔루션은 기업 Active Directory 도메인과 상호 작용하고 내구성이 뛰어나고, AWS 매니지드 여야합니다. AWS와 높은 수준의 처리량 및 IOPS를 제공합니다. 어떤 솔루션이 이러한 기준을 충족합니까?

A. Windows 파일 서버용 Amazon FSx를 사용하십시오.

B. Amazon Elastic File System(Amazon EFS)을 사용합니다.

C. 파일 게이트웨이 모드로 AWS Storage Gateway를 사용합니다.

D. 2개의 가용 영역에 걸쳐 2개의 온디맨드 인스턴스에 Windows 파일 서버를 배포합니다.

A

Windows : FSx

Linux : EFS

(6월6일, 6월16일, 7월26일 기출)

No96.

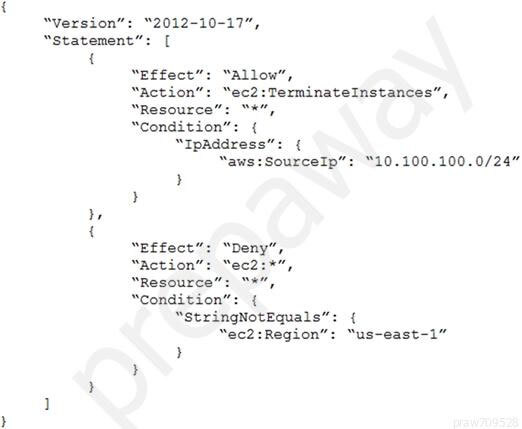

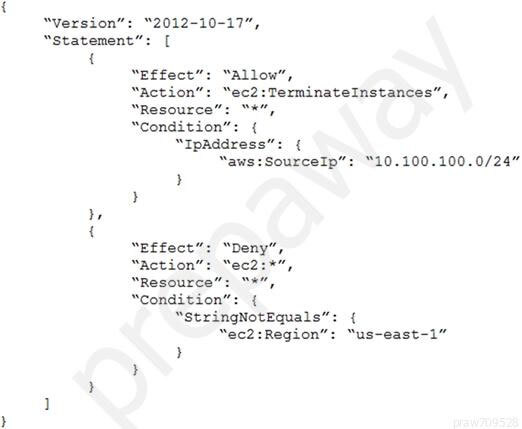

The following policy was developed by an Amazon EC2 administrator and assigned to an IAM group including numerous users:

What impact does this policy have?

A. Users can terminate an EC2 instance in any AWS Region except us-east-1.

B. Users can terminate an EC2 instance with the IP address 10.100.100.1 in the us-east-1 Region.

C. Users can terminate an EC2 instance in the us-east-1 Region when the user's source IP is 10.100.100.254.

D. Users cannot terminate an EC2 instance in the us-east-1 Region when the user's source IP is 10.100.100.254.

다음 정책은 Amazon EC2 관리자가 개발하여 수많은 사용자를 포함하는 IAM 그룹에 할당되었습니다.

이 정책은 어떤 영향을 미칩니까?

A. 사용자는 us-east-1을 제외한 모든 AWS 영역에서 EC2 인스턴스를 종료할 수 있습니다.

B. 사용자는 us-east-1 영역에서 IP 주소가 10.100.100.1인 EC2 인스턴스를 종료할 수 있습니다.

C. 사용자의 소스 IP가 10.100.100.254일 때 사용자는 us-east-1 영역에서 EC2 인스턴스를 종료할 수 있습니다.

D. 사용자의 소스 IP가 10.100.100.254인 경우 사용자는 us-east-1 영역에서 EC2 인스턴스를 종료할 수 없습니다.

C

1. sourcepIP가 일치하는 경우에만 인스턴스 종료(모든) 허용합니다.

2. 요청이 us-east-1 이외의 지역에서 오는 경우 모든 EC2 작업 거부합니다.

(7월1일, 7월11일, 7월21일, 7월24일, 7월25일, 7월26일 기출)

No97.

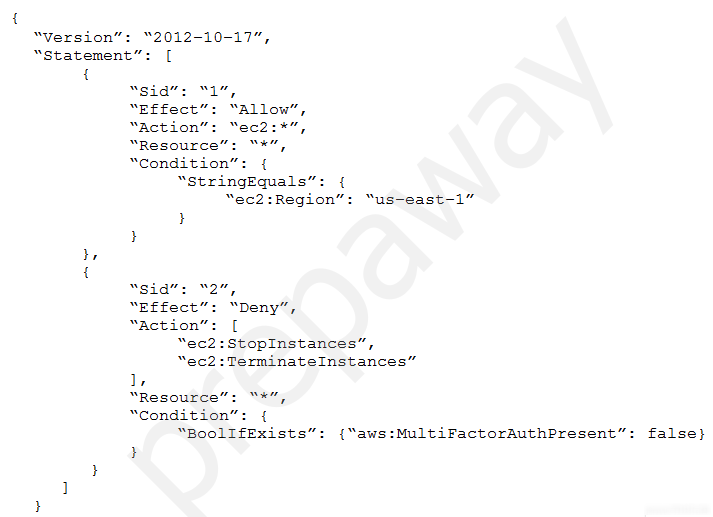

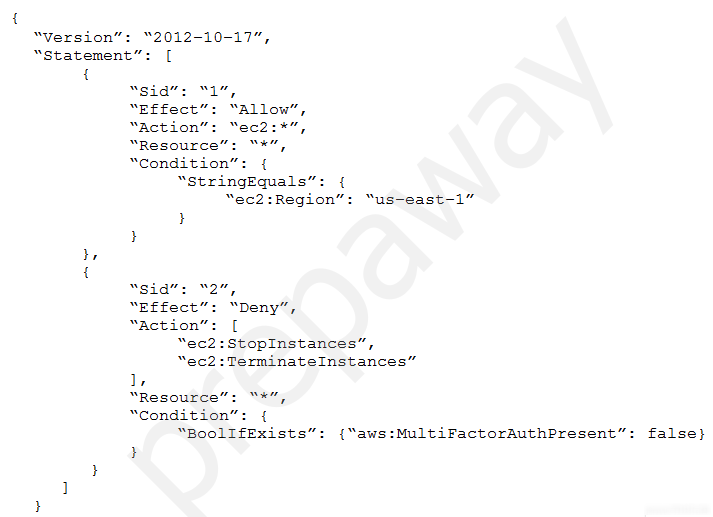

An IAM group is associated with the following IAM policy. This is the group's sole policy.

What are the policy's effective IAM permissions for group members?

A. Group members are permitted any Amazon EC2 action within the us-east-1 Region. Statements after the Allow permission are not applied.

B. Group members are denied any Amazon EC2 permissions in the us-east-1 Region unless they are logged in with multi-factor authentication (MFA).

C. Group members are allowed the ec2:StopInstances and ec2:TerminateInstances permissions for all Regions when logged in with multi-factor authentication (MFA). Group members are permitted any other Amazon EC2 action.

D. Group members are allowed the ec2:StopInstances and ec2:TerminateInstances permissions for the us-east-1 Region only when logged in with multi-factor authentication (MFA). Group members are permitted any other Amazon EC2 action within the us-east-1 Region.

IAM 그룹은 다음 IAM 정책과 연결됩니다. 이것이 그 단체의 유일한 정책이다.

그룹 구성원에 대한 정책의 유효한 IAM 권한은 무엇입니까?

A. 그룹 구성원은 us-east-1 지역 내에서 Amazon EC2 작업을 수행할 수 있습니다. 허용 권한 뒤의 문은 적용되지 않습니다.

B. 그룹 구성원은 다중 요인 인증(MFA)으로 로그인하지 않는 한 us-east-1 영역에서 Amazon EC2 사용 권한을 거부당합니다.

C. 그룹 구성원은 ec2가 허용됩니다.인스턴스 및 ec2 중지:종료MFA(다중 인증)로 로그인한 경우 모든 영역에 대한 인스턴스 권한. 그룹 구성원은 다른 모든 Amazon EC2 작업이 허용됩니다.

D. 그룹 구성원은 ec2가 허용됩니다.인스턴스 및 ec2 중지:종료다중 요인 인증(MFA)으로 로그인한 경우에만 us-east-1 영역에 대한 인스턴스 권한. 그룹 구성원은 us-east-1 지역 내의 다른 Amazon EC2 작업을 수행할 수 있습니다.

D

- 첫번째 정책

정책은 us-east-1 지역의 모든 작업을 허용합니다.

- 두번째 정책

MFA가 없는 사용자에 대해 모든 영역에서 중지 및 종료 거부합니다.

(6월9일 기출)

우리 모두 문제 중간 중간 배너는 한번씩 누르면서 문제 풀어요.

관련글

Leave A Trace :: AWS SAA 최신 기출 문제풀이 #1

papasjh.tistory.com

Leave A Trace :: AWS SAA 최신 기출 문제풀이 #2

papasjh.tistory.com

Leave A Trace :: AWS SAA 최신 기출 문제풀이 #3

papasjh.tistory.com

Leave A Trace :: AWS SAA 최신 기출 문제풀이 #4

papasjh.tistory.com

'Cloud > AWS SAA 모의시험' 카테고리의 다른 글

| AWS SAA 모의시험 #2 문제풀이 (2) | 2022.08.05 |

|---|---|

| AWS SAA 모의시험 #1 문제풀이 (0) | 2022.08.05 |

| AWS SAA 최신 기출 문제풀이 #4 (0) | 2022.08.01 |

| AWS SAA 최신 기출 문제풀이 #3 (3) | 2022.07.30 |

| AWS SAA 최신 기출 문제풀이 #2 (4) | 2022.07.30 |